ツール紹介

NVIDIAがAI特化型パーソナルコンピューティングシステムを発表。世界7大PC・サーバーメーカーとの協業で展開へ

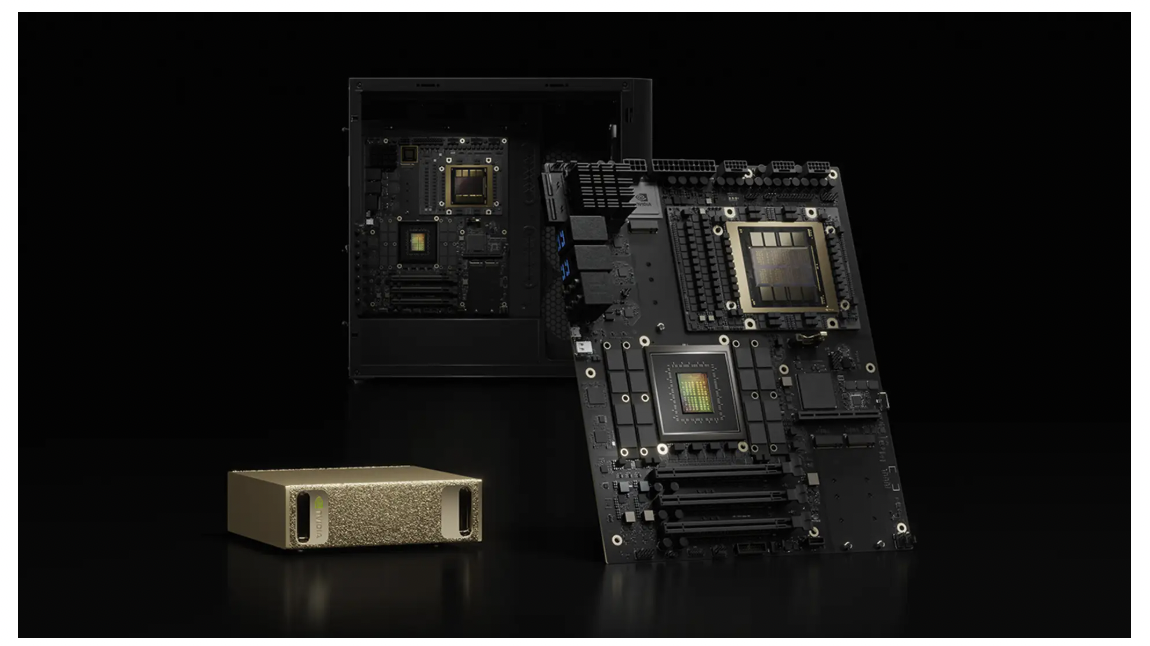

NVIDIAは台湾・台北で開催中のCOMPUTEXにおいて、Acer、ASUS、Dell Technologies、GIGABYTE、HP、Lenovo、MSIといった世界有数のコンピューターメーカーと協業し、AI開発者向けの「DGX Spark」および「DGX Station」パーソナルシステムを発表した。

NVIDIAはAcer、GIGABYTE、MSIとのパートナーシップを拡大することで、個人用AIスーパーコンピューターであるDGX SparkとDGX Stationの可用性を高め、開発者やデータサイエンティスト、研究者に前例のないパフォーマンスと効率性を提供する。

企業やソフトウェアプロバイダー、政府機関、スタートアップ、研究機関は、データサイズや拡張性、独自のモデルプライバシーを犠牲にすることなく、AIサーバーのパフォーマンスと機能をデスクトップ形状で活用できる堅牢なシステムを必要としていた。

特に、自律的な意思決定とタスク実行が可能なエージェント型AIシステムの台頭により、その需要はさらに高まっている。

NVIDIA Grace Blackwellプラットフォームを搭載したDGX SparkとDGX Stationにより、開発者はモデルのプロトタイプ作成、ファインチューニング、推論をデスクトップからデータセンターまであらゆる規模で実行することが可能になる。

DGX Sparkは、NVIDIA GB10 Grace Blackwell Superchipと第5世代Tensorコアを搭載し、最大1ペタフロップスのAIコンピューティングと128GBの統合メモリを提供する。

このシステムはNVIDIA DGX Cloudや各種アクセラレーテッドクラウド、データセンターインフラにモデルをシームレスにエクスポートすることができる。

コンパクトなパッケージながら強力なパフォーマンスと機能を提供するDGX Sparkによって、開発者、研究者、データサイエンティスト、学生は生成AIの限界を押し広げ、業界全体のワークロードを高速化できるようになる。

より高性能なDGX Stationは、最も要求の厳しいAIワークロード向けに設計され、NVIDIA GB300 Grace Blackwell Ultra Desktop Superchipを搭載している。

このモデルは最大20ペタフロップスのAIパフォーマンスと784GBの統合システムメモリを提供し、高速接続とマルチステーションスケーリングのために最大800Gb/sのネットワーク速度をサポートするNVIDIA ConnectX-8 SuperNICも含まれている。

DGX Stationはローカルデータを使用して高度なAIモデルを実行する単一ユーザー向けデスクトップとしても、複数ユーザー向けのオンデマンドタイプの集中型コンピューティングノードとしても機能する。

また、NVIDIAのマルチインスタンスGPU(MIG)テクノロジをサポートしており、それぞれが高帯域幅メモリ、キャッシュ、コンピューティングコアを有するインスタンスとして最大7つまで分割することが可能で、データサイエンスやAI開発チームの個人用クラウドとして活用できる。

両システムとも、最新のNVIDIA AIソフトウェアスタックで事前構成されたNVIDIA DGXオペレーティングシステムを使用しており、NVIDIA NIMマイクロサービスとNVIDIA Blueprintへのアクセスが含まれている。

開発者はPyTorch、Jupyter、Ollamaなどの一般的なツールを使用して、DGX Spark上でプロトタイプ作成、ファインチューニング、推論を実行し、DGX Cloud、アクセラレーテッドデータセンター、クラウドインフラにシームレスに展開できる。

参考・画像元:NVIDIAプレスリリースより

最大20ペタフロップスのAI演算能力とデータセンター級の機能をデスクトップ形状で実現

NVIDIAはAcer、GIGABYTE、MSIとのパートナーシップを拡大することで、個人用AIスーパーコンピューターであるDGX SparkとDGX Stationの可用性を高め、開発者やデータサイエンティスト、研究者に前例のないパフォーマンスと効率性を提供する。

企業やソフトウェアプロバイダー、政府機関、スタートアップ、研究機関は、データサイズや拡張性、独自のモデルプライバシーを犠牲にすることなく、AIサーバーのパフォーマンスと機能をデスクトップ形状で活用できる堅牢なシステムを必要としていた。

特に、自律的な意思決定とタスク実行が可能なエージェント型AIシステムの台頭により、その需要はさらに高まっている。

NVIDIA Grace Blackwellプラットフォームを搭載したDGX SparkとDGX Stationにより、開発者はモデルのプロトタイプ作成、ファインチューニング、推論をデスクトップからデータセンターまであらゆる規模で実行することが可能になる。

DGX Sparkは、NVIDIA GB10 Grace Blackwell Superchipと第5世代Tensorコアを搭載し、最大1ペタフロップスのAIコンピューティングと128GBの統合メモリを提供する。

このシステムはNVIDIA DGX Cloudや各種アクセラレーテッドクラウド、データセンターインフラにモデルをシームレスにエクスポートすることができる。

コンパクトなパッケージながら強力なパフォーマンスと機能を提供するDGX Sparkによって、開発者、研究者、データサイエンティスト、学生は生成AIの限界を押し広げ、業界全体のワークロードを高速化できるようになる。

より高性能なDGX Stationは、最も要求の厳しいAIワークロード向けに設計され、NVIDIA GB300 Grace Blackwell Ultra Desktop Superchipを搭載している。

このモデルは最大20ペタフロップスのAIパフォーマンスと784GBの統合システムメモリを提供し、高速接続とマルチステーションスケーリングのために最大800Gb/sのネットワーク速度をサポートするNVIDIA ConnectX-8 SuperNICも含まれている。

DGX Stationはローカルデータを使用して高度なAIモデルを実行する単一ユーザー向けデスクトップとしても、複数ユーザー向けのオンデマンドタイプの集中型コンピューティングノードとしても機能する。

また、NVIDIAのマルチインスタンスGPU(MIG)テクノロジをサポートしており、それぞれが高帯域幅メモリ、キャッシュ、コンピューティングコアを有するインスタンスとして最大7つまで分割することが可能で、データサイエンスやAI開発チームの個人用クラウドとして活用できる。

両システムとも、最新のNVIDIA AIソフトウェアスタックで事前構成されたNVIDIA DGXオペレーティングシステムを使用しており、NVIDIA NIMマイクロサービスとNVIDIA Blueprintへのアクセスが含まれている。

開発者はPyTorch、Jupyter、Ollamaなどの一般的なツールを使用して、DGX Spark上でプロトタイプ作成、ファインチューニング、推論を実行し、DGX Cloud、アクセラレーテッドデータセンター、クラウドインフラにシームレスに展開できる。

参考・画像元:NVIDIAプレスリリースより

WRITTEN by